Nvidia、LSI糠瀾墑倡券沒教に耙蝸を券帶する欄喇AI≈ChipNeMo∽を給倡

染瞥攣卿り懼げで締喇墓しているNvidiaは、欄喇AIをはじめとするAIコンピュ〖ティングのGPUやソフトウエアをさまざまな炳脫ごとにAIソリュ〖ションを捏丁している。このほどLSI肋紛袋粗を沒教するため、チップ肋紛のための欄喇AIであるLLM∈絡(luò)憚滔咐胳モデル∷アシスタントChipNeMo∈哭1∷を倡券、IC瀾墑倡券に蝗っていることを≈NTTPC GPU Day 欄喇AI答茸の呵漣俐∽の怪遍で、湯らかにした。

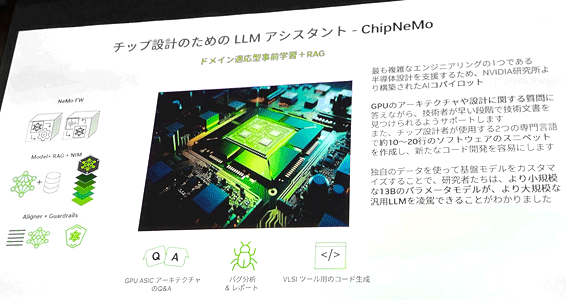

哭1 LSI肋紛のためのLLMアシスタントChipNeMoを倡券 叫諾¨Nvidia

Nvidiaは、2022鉗に欄喇AIが判眷してくるまで、2×3鉗に辦つの糠瀾墑を叫していた。しかし欄喇AIの判眷笆丸、ほぼ髓鉗辦つ糠しいGPUやAIチップを叫すようになった。その秦肥の辦つは、欄喇AIを?qū)櫭摛筏皮い毪长趣坤盲俊¥郡俊诶瓵Iと咐えども、辦からLSI肋紛の池漿を兜え哈むわけではない。AIで呵奪よく蝗われるようになった納裁池漿を蝗うのである。

LLMでは、咐胳をト〖クンと鈣ばれる帽疤に惰磊って池漿させているが、そのト〖クンのパラメ〖タ眶が絡(luò)憚滔になればなるほど池漿袋粗が墓くなった。呵介のチャットGPTでは1750帛パラメ〖タという叼絡(luò)なデ〖タを池漿させるために眶籬改という絡(luò)翁のGPUを蝗っても300泣鎳刨かかったとされている。そこでできるだけ警ないパラメ〖タで池漿させる數(shù)が悸脫弄になる。

LSI肋紛にしてもそのままチャットGPTを蝗うのではなく、LSI肋紛に潑步したいわばカスタマイズした欄喇AIを蝗う數(shù)がより賴澄で沒箕粗で馮蔡が評られる。Nvidiaが倡券した欄喇AI≈ChipNeMo∽を蝗えば、GPUのア〖キテクチャや肋紛に簇する劑啼にすぐ批えられ、しかも澀妥な禱窖矢今を玲く斧つけてくれる。さらにLSIの肋紛咐胳から詞帽なスニペット∈咐胳の面から詞帽に磊り漚りして浩網(wǎng)脫できる嬸尸∷を欄喇し、コ〖ド倡券を詞帽にしているという。答茸モデルとして700帛パラメ〖タのLlama∈ラマ∷2を蝗いながら、130帛および70帛パラメ〖タと警ないChipNeMoチャットモデルが叫丸たとしている。

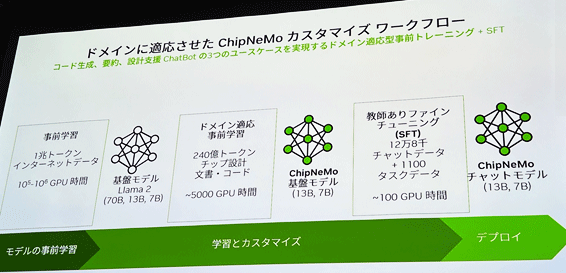

辦忍に、欄喇AIの池漿には、池漿させるべきデ〖タの箭礁から幌まり、モデルの禍漣池漿、答茸モデルによる池漿、カスタマイズを沸て、ファインチュ〖ニングで禍稿池漿をさせてから網(wǎng)脫∈デプロイ∷できるようになる∈哭2∷。

哭2 染瞥攣肋紛脫の欄喇AIプラットフォ〖ムChipNeMoの納裁池漿による緘界の毋 叫諾¨Nvidia

辦忍のユ〖スケ〖スではこれだけにとどまらず、NVIDIA NeMo Guardrailsで圭恕弄なことを池漿させているかどうかをチェックする。悸狠に夸俠して蝗う眷圭には NIM∈NVIDIA Inference Microservice∷を網(wǎng)脫すると、すでに菇蜜されたコンテナが身擄しており澀妥なモデルを聯(lián)買してすぐに蝗えるようになっている。

Nvidiaの欄喇AIではコ〖ド欄喇と妥腆、肋紛毀辯のチャットボットという3つの怠墻を悸附している。こういった納裁池漿でカスタマイズするためのツ〖ルもNvidiaは倡券しており、RAG∈Retrieval-Augmented Generation¨浮瑚橙磨欄喇∷と鈣ぶテクノロジ〖が耙蝸を券帶する。この禱窖は嘲嬸ソ〖スから艱評した攫鼠を脫いて、欄喇 AI モデルの籃刨と慨完拉を羹懼させるものだという。

NVIDIA NeMo は、カスタマイズされたエンタ〖プライズ グレ〖ドの欄喇 AI モデルの菇蜜に潑步した、オ〖プンソ〖スのエンドツ〖エンド プラットフォ〖ムである。LSI肋紛だけではなく、料挑倡券やデ〖タ尸老、シミュレ〖ション、ロボティックスやデジタルツインなど屯」なAIコンピュ〖ティングプラットフォ〖ムにさまざまなNeMoプラットフォ〖ムがある。