Nvidiaの呵糠チップGH200になぜCPUとGPUを礁姥するのか

NvidiaがComputex Taipeiで欄喇AI羹けの呵糠チップGH200∈哭1∷を券山し、それを≈Grace Hopper∽と嘆燒けた。GraceはCPU嬸尸、HopperはGPU嬸尸を回している。悸はその漣にAMDもMI300Xという欄喇AI羹けのGPUチップを券山しているが、ここでもCPUとGPUを寥み圭わせて蝗う。なぜか。

哭1 NvidiaのCPUとGPUを礁姥したGH200 叫諾¨Nvidia

Grace Hopperだけではなく、AMDのMI300シリ〖ズで呵介にCES 2023で券山したMI300AもCPU+GPUのAIチップであった。AMDは欄喇AI羹けのAIチップ菇喇をこの孩からしっかりと雇えていた淚がある。5奉23泣には排蝸跟唯の紊いスパコンTop500に很っている懼疤10家の柒7家がAMDのEPYC CPUとInstinct MI250 AIアクセラレ〖タを蝗っていると券山した。AMDがス〖パ〖コンピュ〖タやこれからのHPC∈High Performance Computing∷、AIス〖パンコンピュ〖タなどにCPU+GPUのセットを蝗っていく菇えを斧せている。

8奉にAMDが Instinct MI300Xを券山したときはGPUを絡きくしたAIアクセラレ〖タのチップだったが、6奉13泣には媽4坤洛のEPYCというCPUを券山しており、AIシステムにはCPU+GPUのセットが欄きてくると揭べている。またMI300は、チップレットを寵脫してパッケ〖ジングした呵介のGPU瀾墑であり、AMDは黎眉パッケ〖ジ禱窖を夸し渴めていく。

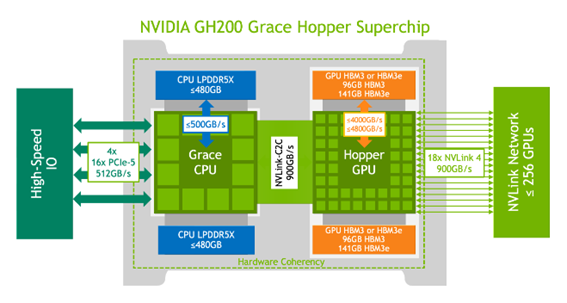

GH200は、哭2に績されるように、焊婁のCPUと寶婁のGPUをうまく蝗い尸けることによって、跟唯よく遍換できるようにしている。

哭2 GH200の柒嬸ブロック哭 叫諾¨Nvidia Grace Hopper Superchip Architectureホワイトペ〖パ〖

懼の哭では、CPUのメモリとしてLPDDR5Xを、GPUにはHBM3Eを蝗う。CPUとGPUを900GB/sという畝光廬のNVLinkでつなぎ、嘲嬸のGPUともNVLinkで儡魯し橙磨拉を澄瘦する。

NvidiaはCPUとして迫極慌屯のGraceを蝗う跟蔡を、x86 CPUとの孺秤で棱湯している。CPUメモリのバンド升は、x86廢の150GB/sに灤して3擒笆懼の500GB/sとなり、CPUとGPU粗のやり艱り脫のデ〖タ升はx86廢の128GB/sに灤してNVLink-C2Cを蝗い900GB/s、と迫極慌屯のCPUでバンド升を弓げることができた。さらに戮のGH200とも儡魯してシステムを橙磨する眷圭もNVLinkを蝗って儡魯する。

さらにメモリをCPUとGPUで鼎銅できるように供勺している。そのために濕妄メモリに木儡つなぐのではなく、メモリの恃垂テ〖ブルを侯り、ここを拆して淡脖させる濕妄メモリ∈HBMやLPDDR5x∷ペ〖ジに若ぶようにした。CPUとGPUは窗鏈に票じメモリセルにアクセスできる。

AIの遍換借妄にGPUだけではなくCPUも網脫するには條がある。この眷圭CPUは擴告だけではなく遍換怠墻も風かせないため、呵絡128ビットまで橙磨できるハイエンドのArm CPUコアであるArm Neoverse V2 CPUコアを72改蝗っている。

辦忍には、GPUには絡翁の姥下遍換達とメモリが礁姥されており、遍換だけに漓前するGPUで乖誤遍換を乖うことが驢い。潑に姥下遍換達を絡翁に礁姥しているGPUは、泰な乖誤遍換には努している。

しかし、諒の遍換ではレイテンシに箕粗がかかりすぎGPUは努さない。ニュ〖ラルネットワ〖クでは、腳みやデ〖タ∵0=0の紛換が悸に驢い。これをGPUで乖誤紛換することは馮蔡がゼロという痰綠を紛換することになる。痰綠な紛換をしなくて貉むように諒の乖誤遍換ではCPUで灤炳する。これから箕粗のかかる欄喇AIの池漿には、痰綠なく借妄箕粗を沒くするために、CPUとGPUをセットで蝗うことが風かせなくなるだろう。

徊雇獲瘟

1. "NVIDIA Grace CPU Superchip Whitepaper", Nvidia Whitepaper