ź╦źÕĪ╝źĒź┴ź├źū▄ć└ŌĪĪĪ┴żżżĶżżżĶ╚ŠŲ│öüż╬Įą╚ų(5-1)

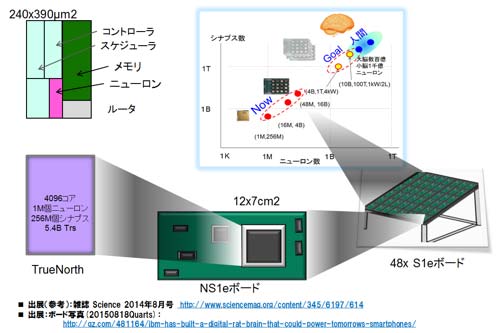

ż│ż╬źĘźĻĪ╝ź║║ŪĖÕż╬ŗī5ŠŽżŽĪóŲ░Ė■ż“║ŻĖÕż╦ż─żżżŲĮęż┘żŲżżżļĪŻØŖż╦ĪóIBMż¼│½╚»żĘż┐TrueNorthź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūż╦ż─żżżŲĪóØŖż╦źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╚żżż”ćĶ┼└ż½żķĖ½ż┐övŽ®╣Į└«żõØŖ─╣ż╩ż╔ż╦ż─żżżŲ▓“└ŌżĘżŲżżżļĪŻĪ╩ź╗ź▀ź│ź¾ź▌Ī╝ź┐źļįćĮĖ╝╝Ī╦

├°ŪvĪ¦ĖĄ╚ŠŲ│öü═²╣®│žĖ”ē|ź╗ź¾ź┐Ī╝Ī╩STARCĪ╦/ĖĄ┼ņėøĪĪ╝å└źĪĪĘ╝

ŗī5ŠŽĪ¦ ź╦źÕĪ╝źĒź┴ź├źūĪ┴╦▄└’ż╦Ų═Ų■Ī¦Ų░Ė■ż╚║ŻĖÕ

║ŪĖÕż╬ŠŽż╚ż╩żļŗī5ŠŽżŪżŽĪųŲ░Ė■ż╚║ŻĖÕĪūż╚¼öżĘżŲĪó║ŪĮķż╦╚»╔ĮżĄżņż┐2014ŃQ8ĘŅż½żķ┘Jż╦2ŃQż“▒█ż©żļ╗■ż¼Ęąż├żŲżżżļż¼Īó║ŪŖZż╬┐ʿʿż╩¾╣żŌżóżĻ┐ʿʿż┤ķż“Ęeż├ż┐ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūżŪżóżļIBMż╬TrueNorthż“║╬żĻæųż▓żļĪŻŗī3ŠŽżŪżŌĮęż┘ż┐ż¼Īó╦▄┤¾ąMżŪżŽTrueNorthż╬╣Į└«Ī”Ų░║Ņż“▄ć└Ōż╣żļż¼Īóź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūż╚żĘżŲ┤³┬įżĄżņżļ┐═┤ųż╬╦Nż╦żĶżĻŖZżż▓╩│ž┼¬ż╩ŖõĀCżĶżĻżŌĪóĖĮ║▀ż╬źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╬żŌż┐żķż╣żóżļ┴T╠Ż├▒ĮŃż╩└Łē”ż╬ŖõĀCżĶżĻ╚µ│ė└Ō£½ż“╣įż”ĪŻ┐ʿʿż┤ķż“Ęeż├ż┐TrueNorthż“░ĄĮ╠ż╚żżż”└┌żĻĖ²ż½żķż╬▓“└ŌżŌ╗Ņż▀żļĪŻ├µ╚ūż╬5.2£IżŪżŽ╦▄┤¾ąMż╬Č\Įčż╬║ŪĖÕż╬└Ō£½ż╚żĘżŲĪóź═ź├ź╚źŌźŪźļż╬Ė·╬©▓Įż╚░ĄĮ╠Č\Įčż╬╣ńöüż╦żĶżĻĪóżŌż┐żķżĄżņżļ▐k─Ļźņź┘źļż╬ē|Č╦ż╬ųeż╦┌ģżļĪŻżĮżĘżŲ║ŪĖÕż╦5.3£IżŪ║ŻĖÕż╬▓▌¼öż“▄ć└Ōż╣żļĪŻ

5.1ĪĪź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūĪ┴övŽ®╣Į└«ż╚źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż½żķĖ½ż┐░╠Åø¤²ż▒

5.2ĪĪē|Č╦ż╬ųeżžĪ╩▐k─Ļż╬źņź┘źļżžĪ╦Ī┴źĘź¾źūźļż╩źŌźŪźļżžż╬┼¼├ōż╚NMTżžż╬·t│½Ī┴

5.3ĪĪ║ŪĖÕż╦Ī┴║ŻĖÕż╬Ų░Ė■ż╚▓▌¼öĪ┴

5.1ĪĪź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūĪ┴övŽ®╣Į└«ż╚źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╬£å┼└ż½żķż╬░╠Åø¤²ż▒

╦▄£IżŪżŽź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ź┴ź├źūż╚żĘżŲĪóIBMż¼DARPAż╬SynapseźūźĒźĖź¦ź»ź╚ż╬▐k┤─ż╚żĘżŲĖ”ē|Ī”│½╚»żĘĪó2014ŃQ8ĘŅż╦╗©╗’ScienceżŪ╚»╔ĮżĘż┐TrueNorthż“ŲDżĻæųż▓żļĪ╩╗▓╣═½@╬┴84Īó85Ī╦ĪŻżĮż╬╣Į└«ż“└Ō£½ż╣żļż╚ż╚żŌż╦źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╚żżż”Č╦żßżŲ╣®│ž┼¬ż╩ćĶ┼└ż½żķż│ż╬ź┴ź├źūż“Ė½żŲż▀żļĪŻżĮż╬ż┐żßĪóĄšż╦ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»┼¬ż╩═ū┴Ūż╦┤žżĘżŲżŽČ╦╬üį~Ęķż╦Įęż┘żļĪŻ

(1)▄ć═ūĪ”Ī”Ī”┐═┤ųż╬╦N╝┬ĖĮż“ų`╗žżĘżŲ

SynapseźūźĒźĖź¦ź»ź╚ż╬║ŪĮ¬ų`║YżŽĪó┐═┤ųż╬╦Nż╬╝┬ĖĮżŪżóżļĪ╩2020ŃQ░╩æTż½Ī®Ī╦ĪŻ┐└Ęą║┘╦”ż╦┴Ļ┼÷ż╣żļź╦źÕĪ╝źĒź¾ż╚źĘź╩źūź╣Ī╩źßźŌźĻĪ╦ż½żķż╩żļź│źóĪ╩256ź╦źÕĪ╝źĒź¾ż“ŲŌē┼Ī╦ż“64Ī▀64ż╬źóźņźżėXż╦Ū█ÅøżĘĪó╣ń╝Ŗ4096ź│źóż“ĮĖ└čżĘż┐TrueNorthź┴ź├źūĪ╩17mmĪ▀25mmĪ╦ż¼┐▐43ż╬║Ė▓╝ż╦┐āż╣żĶż”ż╦╣Į└«żĄżņżļĪ╩╗▓╣═½@╬┴84Ī╦ĪŻ2014ŃQż╦╚»╔ĮżĄżņż┐ź┴ź├źūż└ĪŻ2014ŃQż½żķ2015ŃQż╦²Xż▒żŲĪóNS1ŻÕź▄Ī╝ź╔ż“IBMżŽĮo│½żĘ╗Žżßż┐ĪŻ▐kż─ż╬TrueNorthź┴ź├źūż¼║▄ż├żŲżżżļĪŻżĮżŌżĮżŌĪóTrueNorthż╬źóĪ╝źŁźŲź»ź┴źŃżŽĪóź│źóż½żķż╬źčź▒ź├ź╚─╠┐«ż“┤╦▄ż╚żĘżŲżżżļż│ż╚ż½żķĪó═²„[┼¬ż╦żŽźĘĪ╝źÓźņź╣ż╦ź│źó│╚─źĪóź┴ź├źū│╚─źż¼▓─ē”żŪ┼÷─śź▄Ī╝ź╔│╚─źżŌ═Ų░ūż└ĪŻ2015ŃQžöż╦żŽĪó┐▐ż╬īÜ▓╝ż╦┐āż╣żĶż”ż╦48ź▄Ī╝ź╔ż“Žóż═ż┐48Ī▀ż╬źĘź╣źŲźÓż“Įo│½żĘżŲżżżļ(╗▓╣═½@╬┴105Īó106ż“╗▓Š╚)ĪŻ╣³│╩ż└ż▒ż└ż╚Īó┐▐ż╬īÜæųż╬┘UŲ■┐▐ż╦┐āż╣żĶż”ż╦Īó┐═┤ųż╬╦Nż╦×┤żĘżŲ1/1000ż╬ź▌źĖźĘźńź¾ż▐żŪ═ĶżŲżżżļĪŻżĮżņ░╩æT║ŪŖZ(2017ŃQØi╚Š)ż▐żŪæä╠Ž│╚Įjż╬Š╩¾żŽż╩żżĪŻ

┐▐43ĪĪTrueNorthż╬ź│źóĪóź┴ź├źūĪóź▄Ī╝ź╔╣Į└«ż╚ĪóźūźĒźĖź¦ź»ź╚ż╬ų`║Yź╚źņź¾ź╔

╗▓╣═½@╬┴84Īó85ż“╗▓╣═ż╦║Ņ└«Īóź▄Ī╝ź╔Š╩¾żŽ╗▓╣═½@╬┴105Īó106.

┐▐44ż╦TrueNorthż╬▄ć═ū▐k═„ż“┐āżĘż┐ĪŻ┐▐43ż╬ź╦źÕĪ╝źĒź¾övŽ®Ī╩śĘ┐¦ŗĪ╦ż“╗■╩¼│õ¾H─_żŪ╗╚żżż▐ż’ż╣Īóżżż’żµżļ▓Š„[ź╦źÕĪ╝źĒź¾öĄ╝░żŪżóżļĪŻ1ż─ż╬ź╦źÕĪ╝źĒź¾övŽ®ż“1msecż╦256öv╗╚żżövż╣ĪŻż▐ż┐ź»źĒź╣źąĪ╝öĄ╝░ż“├ōżżżŲżżżļż¼ĪóŲ▒żĖż»▓Š„[ź»źĒź╣źąĪ╝öĄ╝░żŪżŌżóżļĪŻ▓Š„[żŪżóżļż│ż╚ż“Į³ż»ż╚Īóż▐żĄżĘż»SRAMĪ╩źßźŌźĻźóźņźżż╚└čŽ┬▒ķōQŗżŽ║ŪŖZ└▄ż╦Ū█ÅøżĄżņżŲżżż╩żżż¼Ī╦żŪżóżļĪŻŲ■╬ü(źĒĪ╝)ŖõżŽ256Ė─ż╬╝┤║„(źóź»źĮź¾Ī¦Axon)ĪóĮą╬üĪ╩ź½źķźÓĪ╦ŖõżŽ256Ė─ż╬ź╦źÕĪ╝źĒź¾ż¼╩┬żųĪŻź»źĒź╣ż╬ź▌źżź¾ź╚ż¼256Ī▀256ż╚ż╩żĻźĘź╩źūź╣└▄¶öż“Ę┴└«ż╣żļĪŻź½źķźÓöĄĖ■ż╦└čŽ┬ż╬ĮĶ═²ż“╣įż”ĪŻ╝┬║▌ż╦żŽ└čŽ┬ż╬║ŅČ╚żŽ1źĒĪ╝╦Ķż╦╣įż’żņżļĪŻź│ź¾ź╚źĒĪ╝źļövŽ®żŪźóź»źĮź¾żžż╬Ų■╬ü├═Ī╩0, 1Ī╦ż╚źĘź╩źūź╣└▄¶öŠ╩¾(0,1)ż╬└čż“ż╚żĻĪóŠ╩¾(1ż╬ż▀)ż“ź╦źÕĪ╝źĒź¾övŽ®ż╦┼Ļż▓żļĪŻż│ż╬║ŅČ╚ż“ź½źķźÓöĄĖ■ż╦źĘĪ╝ź▒ź¾źĘźŃźļż╦Ę½żĻ╩ųżĘ╣įż”ĪŻ

▐köĄĪóź╦źÕĪ╝źĒź¾övŽ®żŪżŽź│ź¾ź╚źĒĪ╝źļövŽ®ż½żķż╬Š╩¾(1)ż“£pż▒ĪóżĮż╬┼į┼┘ĪóźĒĪ╝╚ų├ŽĪ╩źóź»źĮź¾Ī╦Īóź½źķźÓ(ź╦źÕĪ╝źĒź¾)╚ų├ŽżŪ»éż▐żļźĘź╩źūź╣╔ķ▓┘ż“ĖĄż╦ź╦źÕĪ╝źĒź¾źŌźŪźļż╦“£żż▒ķōQżĘŠ“°Pż¼┼Dż©żąź╣źčźżź»Įą╬üż“Įąż╣ĪŻĮą╬üżŽź╣źčźżź»ż╚żĘżŲź┴ź├źūæųż╬ź│źóĪóżŌżĘż»żŽ┬Šż╬ź┴ź├źūż╬ź│źóżžźļĪ╝ź┐ż“▓żĘżŲźčź▒ź├ź╚ż╚żĘżŲ┼┴ś“żĄżņżļĪŻż╩ż¬Īó│žØ{ż╬ĄĪē”żŽ┼ļ║▄żĄżņżŲżżż╩żżĪŻ╝┬╣įż└ż▒ż╬ź┴ź├źūżŪżóżļĪŻ

┐▐44ĪĪTrueNorthż╬▄ć═ū╗┼══ (╗▓╣═½@╬┴84Īó85ż“╗▓╣═ż╦║Ņ└«)

┼Š║▄ĖĄĪ¦STARCżŪż╬─┤Øh╩¾╣Į±żĶżĻ┼Š║▄.

ĘQ¹|ż╬ź═ź├ź╚ź’Ī╝ź»źŌźŪźļż╚źŽĪ╝ź╔Ī╩TrueNorthĪ╦ż╚ż╬źżź¾ź┐Ī╝źšź¦Ī╝ź╣żŽź│źóźņź├ź╚ż╚żżż”źūźĒź░źķźÓ┤─ČŁż╦żĶżĻ└▄¶öżĄżņżļĪŻ▒■├ō╬Ńż╚żĘżŲ¾HرöüĖĪē¶Ī”Ū¦╝▒żŪ73mWĪó800GOPS/Wż╬└Łē”ż╬╩¾╣ż¼żóż├ż┐ĪŻ─ŃŠ├õJ┼┼╬üżŪżóżļż│ż╚ż½żķź©ź├źĖ▒■├ōż“┼÷ĮķżĶżĻ┴└ż├żŲżżżļĪŻØŖż╦2015ŃQžöżĶżĻä▌╣±ż╦żŲĪ╔ Brain-inspired Computing Boot CampĪ╔Īżż╩żļżŌż╬ż“╝ń╠¢Ī╩╗▓╣═½@╬┴107Ī╦Īó¾Hż»ż╬ä▌╣±ż╬Įj│žż“├µ┐┤ż╦┐¶Ø▓ż╬Ė”ē|ĄĪ┤žż¼╗▓▓├Īóź©ź├źĖÅUż“ź┐Ī╝ź▓ź├ź╚ż╚żĘż┐źóźūźĻź▒Ī╝źĘźńź¾żžż╬╝┬├ō▓Įż╬īÖŲ░ż“┘M¶öżĘżŲż¬żĻĪó║ŪŖZżĮż╬└«▓╠ż“╚»╔ĮżĘż┐(▐kŗ/╗▓╣═½@╬┴108)ĪŻż│ż╬źŁźŃź¾źūżŽ╗─Ū░ż╩ż¼żķ╣±╦╔Š╩ż¼┤žŽóżĘżŲż¬żĻĪóŲ³╦▄ż½żķż╬╗▓▓├żŽžMżĘżżżĶż”ż└

(2)övŽ®╣Į└«

─_╩Żż╣żļ┼└żŌżóżļż¼ĪóövŽ®╣Į└«ż╦┤žżĘżŲ┐▐45ż“├ōżżżŲį~├▒ż╦└Ō£½ż╣żļĪŻ╗▓╣═½@╬┴85ż“╗▓╣═ż╦║Ņ└«żĘżŲżżżļĪŻż½ż╩żĻ╩Ż╗©ż└ĪŻŲ■╬üŖõż╦256Ė─ż╬Ų■╬ü(╝┤║„Ī¦źóź»źĮź¾)ż╬├╝╗ęż¼żóżĻĪóż½ż─16ź╣źŲź├źū(1msż┤ż╚Īó16msż▐żŪ)ż╬╗■┤ųż“─┤┼DżŪżŁżļ16Ī▀256źėź├ź╚ż╬źßźŌźĻź▐ź╚źĻź»ź╣ż“ż¬ż½żņżŲżżżļĪŻź└źżź╩ź▀ź├ź»ż╦╗■┤ų─┤┼Dż“ż╣żļżŌż╬żŪżŽż╩ż»ĪóĄ£Øiż╬ź¬źšźķźżź¾żŪ╣įż├ż┐│žØ{ż╬±T▓╠ż╦“£ż├ż┐ź╣ź┐źŲźŻź├ź»ż╩ź═ź├ź╚ź’Ī╝ź»źŌźŪźļż“╣Į└«ż╣żļż┐żßż╬żŌż╬żŪżóżļĪ╩ĖĮ╗■┼└żŪż╬╔«Ūvż╬═²▓“Ī╦ĪŻŲŌŗżŽØÖŲ▒┤³żŪżŽżóżļż¼Īóź░źĒĪ╝źąźļź»źĒź├ź»(1ms╝■┤³)ż╦żĶżĻŲ▒┤³żĄż╗żļż┐żßż╬ź┐źżź▀ź¾ź░─┤┼D├ōżŪżŌżóżļĪŻ

ź»źĒź╣źąĪ╝ż╬ź»źĒź╣ź▌źżź¾ź╚żŽĪóźąźżź╩źĻĪ╝źėź├ź╚Ī╩0Īó1Ī╦ż½żķż╩żļ└▄¶öŠ╩¾ż╬ż▀ż“Ń~ż╣żļźĘź╩źūź╣└▄¶öżŪżóżļĪŻżĮżņż╦▓├ż©żŲĪóŲ■╬üźĒĪ╝Ŗõż╬źóź»źĮź¾ż╚Įą╬üŖõż╬ź╦źÕĪ╝źĒź¾żŪ»éż▐żļźĘź╩źūź╣ĘĖ┐¶ż╚Š╬ż╣żļ─_ż▀ż“Ęeż├żŲżżżļĪŻ4¹|╬Óż╬9źėź├ź╚Ī╩-256Ī┴255Ī╦ż╬─_ż▀ż└ĪŻ¹|╬ÓżŽźóź»źĮź¾ż╦żĶżĻ»éż▐żĻĪó9źėź├ź╚ż╬├═żŽź╦źÕĪ╝źĒź¾ż╦żĶżĻ»éż▐żļ╗┼┴╚ż▀ż└ĪŻČĮ╩│└Ł(źūźķź╣)ż╚ż½═▐öU└ŁĪ╩ź▐źżź╩ź╣Ī╦ż╚żżż├ż┐ź┐źżźūżŽźóź»źĮź¾ŖõżŪ»éżßżŲĪóżĮż╬─_ż▀Ī╩ĮjżŁżĄĪ╦żŽż╚ż╩żļż╚ź╦źÕĪ╝źĒź¾ŖõżŪ»éż▐żļż╚żżż”ż│ż╚ż└ĪŻź│Ī╝ź╔źųź├ź»ż¼├ō┴TżĄżņżŲżżżļĪŻ│žØ{ż╬├╩│¼żŪż│ż╬╔ĮżŽ»é─ĻżĄżņSRAMż╦│╩Ū╝żĄżņżļĪŻżĮż╬┼└ż½żķĪóTrueNorthżŽźąźżź╩źĻĪ╝ż╚Ė└ż’żņżŲżżżļż¼ØŁż║żĘżŌżĮż”żŪżŽż╩żżĪŻż▐ż┐ĖÕżŪĮęż┘żļż¼Īóź│Ī╝ź╔źųź├ź»ż“╗╚├ōż╣żļ┼└żŽØi£I4.3£IżŪĮęż┘ż┐╬╠╗ę▓Įż╬▐kż─żŪżóżļź»źķź╣ź┐źĻź¾ź░ż╚Ų▒żĖż└ĪŻ

ź½źķźÓöĄĖ■ż╦źĒĪ╝╦Ķż╦Šd╝Ī╝ŖōQżĄżņżļ±T▓╠ż¼ź╦źÕĪ╝źĒź¾övŽ®ż╦Ų■żĻĪóżĮż╬┼į┼┘Ž┬ż╬ĮĶ═²ż¼╣įż’żņżļĪŻź▌źŲź¾źĘźŃźļż¼╩č▓Įż╣żļĪŻ±T▓╠Īó├▒ĮŃż╦żŽĄ£Øiż╦»éżßżķżņżŲżżżļżĘżŁżż├═żĶżĻĮjżŁż»ż╩żņżąź╣źčźżź»ż¼Įą╬üżĄżņĪóĄšż╦Š«żĄż▒żņżąź╣źčźżź»żŽ╚»Ö┌żĘż╩żżĪŻź╣źčźżź»╚»Ö┌ĖÕżŌżĘż»żŽź░źĒĪ╝źąźļź┐źżź▀ź¾ź░1msec╦Ķż╦ź╝źĒż╦źĻź╗ź├ź╚żĄżņżļĪŻ░╩æųż¼źčźļź╣Ų■╬üż½żķĪóźčźļź╣Įą╬üż▐żŪż╬Š}Įńż└ĪŻżĘżŁżż├═ż“Ęeż─┼└żŽØi£I4.3£Iż╬Pruningż╦ō¶żŲżżżļĪŻ╣ūĖź┼┘ż╬Š»ż╩żżĪ╩─_ż▀ż¼Š«żĄżżĪ╦żŌż╬żŽ║ŪĮķż½żķ╗▓▓├żŌß׿Ążņż╩żżĪŻź└źżź╩ź▀ź├ź»ż╦ĮĶ═²żĄżņżļ┼└żŪżŽŲ▒żĖż»Øi£I4.3ż╬ź╝źĒź╣źŁź├źūż╦ŖZżżż╚╣═ż©ż┐öĄż¼╬╔żżż½żŌżĘżņż╩żżĪŻ

éb╩Ėż╦żĶżļż╚▐k╬Ńż╚żĘżŲ100Ų■╬üż╦×┤żĘżŲ1övż╬źčźļź╣ż¼ĮążļżĶż”ż╦żĘżŁżż├═öUĖµżĄżņżļż╬ż¼║YØŹż╬żĶż”ż└ĪŻ1ź│źó┼÷ż┐żĻ5ź╣źčźżź»/1msµć┼┘ż╚ż╬ż│ż╚ż└ĪŻĮą╬üżŽż½ż╩żĻšÅ(Sparse)ż└ĪŻżŌż┴żĒż¾żĮż╬╔č┼┘żŽ╔w─ĻżŪżŽż╩żżĪŻżĘżŁżż├═ż“─Ńż»ż╣żņżąźčźļź╣ż╬╔č┼┘żŽ╣Ōż▐żĻĪó▒ķōQ└Łē”żŽæųż¼żļż¼Ų▒╗■ż╦╚µ╬ѿʿŲŠ├õJ┼┼╬üżŌæųż¼żļĪŻżĘżŁżż├═ż“─Ńż»ż╣żļż╚10Ū▄µć┼┘żŽ╔č┼┘ż¼æųż¼żļżĶż”ż└ĪŻż│ż╬╔č┼┘Īóż╣ż╩ż’ż┴żĘżŁżż├═ż¼─ŃŠ├õJ┼┼╬üżĄżķż╦żŽŲ░║ŅÅ]┼┘ż╬═ūż╦ż╩ż├żŲżżżļ┼└ż¼IF (Integrate and Fire)Ę┐ź╦źÕĪ╝źĒź¾źŌźŪźļż╬ØŖ─¦żŪżóżļĪŻ─╠Š’ż╬FLOPS(Floating-point Operations Per Second)ż╚żżż”└Łē”╔ĮĄŁż╦×┤żĘżŲĪó▐kövż╬źčźļź╣╚»Ö┌ż“Synaptic Operationż╚Ė½ż╩żĘż┐SOPS (Synaptic Operations per second)ż╚żżż”└Łē”╔ĮĄŁż“╗╚├ōżĘżŲżżżļĪŻFLOPSż╚SOPSż╬╚µ│ėżŽžMżĘżżĪŻSOPSż╬▓┴├═żŌ£½│╬ż╦ż╣żļØŁ═ūż¼żóżļĪŻ╬Ńż©żą░═┘T└Łż╬ĮjżŁżżżĘżŁżż├═ż¼▓┐ż╦żĶż├żŲ»éż▐żļż½ż╬─Ļ└Ł┼¬żŌżĘż»żŽ─Ļ╬╠┼¬ż╩═²▓“ż¼═▀żĘżżĪŻź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŪżŌPruningż╩żĻź╝źĒź╣źŁź├źūĪ󿥿ķż╦żŽ╬╠╗ę▓Įż“╗▄żĘż┐║▌Īó╝┬Ė·ĮĶ═²Å]┼┘ż╚żżż”╔ĮĖĮż“├ōżżżļż│ż╚ż¼żóżļĪŻż│żņż╦ŖZżż╣═ż©öĄż¼═²▓“żĘżõż╣żżż╚╣═ż©żŲżżżļĪŻ

Įą╬üżŽź╣źčźżź»ż╚żĘżŲź╦źÕĪ╝źĒź¾övŽ®ż½żķźļĪ╝ź┐ż“─╠żĘżŲĪóźčź▒ź├ź╚ż╚żĘżŲų`┼¬ż╬╚ų├Žż╦┴„żķżņżļĪŻź┴ź├źūĪóź│źóż╬╚ų├ŽĪóżĮżĘżŲźóź»źĮź¾ż╬źĒĪ╝Ī╩╣įĪ╦ż╬╚ų├Žż½żķż╩żļź═ź├ź╚└▄¶öŠ╩¾ż└ĪŻ╗■┤ųŠ╩¾żŌ¤²▓├ż╣żļĪŻźóź»źĮź¾ęÆūāż╚Š╬ż╣żļ1msecż“├▒░╠ż╚ż╣żļź┐źżź▀ź¾ź░Š╩¾ż└ĪŻź╣źčźżź»ż╬ź│źó┤ųż╬Ų▒┤³ż“ż╚żļż┐żßż└ż▒ż╦╗╚├ōżĄżņżŲżżżļĪŻźčź▒ź├ź╚Š╩¾żŽĪó│žØ{╗■ż╬├╩│¼żŪ»éżßżķżņżļĪŻź╣ź┐źŲźŻź├ź»ż╩ź═ź├ź╚ź’Ī╝ź»╣Į└«ż“»éżßżļż┐żßż└ĪŻż╩ż¬Īó│žØ{╗■ż╦żŽżĄżķż╦źĘź╩źūź╣╔ķ▓┘ż¬żĶżėźĘź╩źūź╣└▄¶öżŌ»éżßżļĪŻź═ź├ź╚╣Į└«ż¼»éż▐żĻĪó─_ż▀żŌ»éż▐żņżą│žØ{żŪż╬ź═ź├ź╚ź’Ī╝ź»źŌźŪźļżŽ┤░└«ż╣żļĪŻ╝┬╣įż╬Øiż╦źčź▒ź├ź╚Š╩¾ż╚╔ķ▓┘Īó└▄¶öŠ╩¾żŽź│źóŲŌż╬SRAMż╦ź╣ź╚źóżĄżņżļĪŻ

┐▐45ĪĪTrueNorthż╬övŽ®öĄ╝░Ī¦ Ī╩╗▓╣═½@╬┴85ż“╗▓╣═ż╦║Ņ└«żĘż┐Ī╦

ĮąųZĖĄĪ¦STARCżŪż╬─┤Øh╩¾╣Į±żĶżĻ┼Š║▄

(3)ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»/TrueNorthż╬ØŖ─¦ż╚Ų░Ė■Ī┴źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╚ż╬▓═ż▒ČČ

ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»żŽĪóźąźżź╩źĻĪ╝Ī╩TrueNorthżŪżŽ┘ć│╬ż╦żŽŲ■Įą╬üźŪĪ╝ź┐ż╬ż▀Ī╦żŪż╬▒ķōQĮĶ═²ż╦▓├ż©żŲź╣źčźżźŁź¾ź░żŪż╬Š╩¾┼┴ś“ż¼šÅżŪżóżļż│ż╚ż½żķĪóżĮż╬─ŃŠ├õJ┼┼╬ü└Łż¼╝┬├ō┼¬ż╦żŽ╠ź╬üż└Ī╩╩Ż┐¶Ø±öüĖĪē¶ż¼70mWĪ╦ĪŻżĮż”ż╩żļż╚ĪóźŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░ż╬Š}╦Īż“╝┬äóżŪżŁż╩żżż½Īóż╚żĻż’ż▒║▌ż└ż├ż┐└«▓╠ż“æųż▓żŲżżżļCNNĪ╩┘ćżĘż»żŽøQ╣■ż▀ż╬Č\ĮčĪ╦ż“ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»æųż╦╝┬äóżŪżŁż╩żżż½ż╚┤³┬įżĄżņżŲżŁż┐ĪŻ║Żż▐żŪż╩ż½ż├ż┐╬ŠŪvż╦ČČż“▓═ż▒żļŲD┴╚ż▀ż└ĪŻ

╝┬żŽż│ż╬ż│ż╚żŽĪó2014ŃQ╚»╔Į┼÷╗■żĶżĻĄ─ébżĄżņżŲżżżļČ╣▒Iż╬ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»ż╚ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ż╬ż╔ż┴żķż¼═źżņżŲżżżļż½ż╚żżż”Ą─ébż╦▐k─Ļż╬╚Įéāż¼ĮążļŲD┴╚ż▀żŪżŌżóżļĪŻ├µĪ╣žMżĘżżż╚ŃŖżņ╩╣ż│ż©żŲżżż┐ż¼Īó2015ŃQĖÕ╚ŠżĶżĻ2016ŃQ11ĘŅż╦ż½ż▒żŲéb╩Ė╩¾╣Ī╩╝┬║▌żŽ▓■ÖÄż¼Ę½żĻ╩ųżĄżņĪ╦ż¼żóżĻ┐╩·tż¼┼┴ż©żķżņżŲżżżļż╬żŪĪóż│ż╬╣ÓżŪżĮż╬Č\Įč┼¬ż╩ŲŌ═Ųż“▓“└Ōż╣żļĪŻėXČĘż“Ė└ż”ż╚├µĪ╣╚Įéāż¼žMżĘżżĪ󊻿Ę═²▓“ż╣żļż╬ż╦╗■┤ųż¼²Xż½żļż╚żżż”ėXČĘżŪżóżļĪŻ

▓▌¼öżŽĪó░╩▓╝ż╬Ų¾ż─żŪżóżļĪŻ

-ź╣źčźżźŁź¾ź░ż╚ĖĒ║╣Ąš┼┴ś“╦ĪĪ╩źąź├ź»źūźĒźčź▓Ī╝źĘźńź¾╦ĪĪ╦ż╬╚∙╩¼ż╚┴Ļ└Łż¼╬╔ż»ż╩żżĪ╩╦▄ä®Ī╦

-ź»źĒź╣źąĪ╝öĄ╝░ż╚øQ╣■ż▀┴žż╬┴╚ż▀╣ńż’ż╗ż¼žMżĘżżĪ╩╝┬├ōæųż╬▓▌¼öĪ╦

TrueNorthż╬źūźĒźĖź¦ź»ź╚ż╬źßź¾źąĪ╝żĶżĻ2015ŃQ¼Ź░╩═Ķ2ż─ż╬─¾░Ųż¼ż╩żĄżņż┐ĪŻŗī2ŠŽż╬2.8£IżŪŠę▓żĘż┐╗▓╣═½@╬┴43ż╚44Ī╩║Ū┐Ę╚ŪżŽ110Īó120Ī╦żŪżóżļĪŻØiŪvżŽ2015ŃQ12ĘŅż╬NIPSĪ╩The Conference and Workshop on Neural Information Processing SystemsĪ╦żŪ╚»╔ĮżĄżņż┐ĪŻĖÕŪvżŽĪó2016ŃQż╬3ĘŅż╬Įķ╚Ūż“╚ķ└┌żĻż╦║ŪĮ¬╚Ūż¼Ų▒ŃQ10ĘŅż╦╚»╔ĮżĄżņż┐ĪŻ2ż─ż╚żŌCoreletż╬│½╚»ż╦Ę╚ż’ż├ż┐źĮźšź╚ź”ź¦źóź©ź¾źĖź╦źóż╬EsserĢ■ż╬╚»╔ĮżŪżóżļĪŻµ£öüż╬źĘź╣źŲźÓż╦┤žżĘżŲżŽ▀Ę┼─ĮYĢ■ż¼éb╩Ėż╚żĘżŲ╚»╔ĮżĘżŲżżżļĪ╩╗▓╣═½@╬┴120Ī╦ĪŻ

(źó) Constrain then train╦ĪĪ”Ī”Ī”2ż─ż╬ź═ź├ź╚ź’Ī╝ź»żŪż─ż╩ż░Ī¬

╚Óżķż╬2015ŃQNIPSżŪż╬─¾░Ųż“▓“└Ōż╣żļĪŻŠ}╦Īż╦ć@Š╬ż¼ż╩ż½ż├ż┐ż╬żŪĪó╩žĄ╣æų╔«Ūvż╬╝ń─źż╣żļŠ}╦Īż╬ØŖ─¦ż“╗╚żż╠┐ć@żĄż╗żŲżŌżķż├ż┐Ī╩╗▓╣═½@╬┴43Ī╦ĪŻź╚ź▌źĒźĖĪ╝ż¼Ų▒żĖĪó2ż─ż╬│žØ{├ō(Training network)ż╚╝┬╣į├ōĪ╩Deployment networkĪ╦ż╬ź═ź├ź╚ź’Ī╝ź»ż“├ō┴Tż╣żļĪŻ┐▐46ż╦éb╩Ėż“╗▓╣═ż╦║Ņ└«żĘż┐Š}╦Īż“┐āżĘż┐ĪŻ

┐▐46ĪĪConstrain then train╦ĪĪ¦ │žØ{╗■żŽöU╠¾ż“£pż▒│╬╬©┼¬ĮĶ═²Īó╝┬╣įżŽ═┐¶ż“├ōżżżŲ┼²╝Ŗ┼¬ĮĶ═²Ī╩╗▓╣═½@╬┴43ż“╗▓╣═ż╦║Ņ└«żĘż┐Ī╦.

ż▐ż║│žØ{Ī╩┐▐ż╬║ĖŖõĪ╦żŪżŽĪó─╠Š’ż╬ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»ż╬┐¶├═ż╦öU╠¾(Constrain)ż“═┐ż©żļĪŻż╣ż╩ż’ż┴Ų■Įą╬üĪ╩Ż°iĪ╦ż¬żĶżėźĘź╩źūź╣╔ķ▓┘├═(cij)ż“0Ī┴1ż╬šJ░Žż╦╩č┤╣ż¬żĶżėĖ┬─ĻżĘżŲŲDżĻ░Ęż”Ī╩╚ÓżķżŽż│żņż“öU╠¾ż╚Š╬żĘżŲżżżļĪ╦ĪŻĖ└ż”ż▐żŪżŌż╩ż»Žó¶ö├═ż╩ż╬żŪĖĒ║╣Ąš┼┴ś“╦ĪżŪż╬│žØ{ż¼▓─ē”ż└ĪŻźĘź╩źūź╣╔ķ▓┘Š╩¾ż╚źąźżźóź╣├═Ī╩┐▐ż╦żŽ└▄¶öŠ╩¾ż╬ż▀Ī╦ż“│žØ{źčźķźßĪ╝ź┐ż╚żĘżŲŲ│ĮążŪżŁżļĪŻżĮżņżŠżņ0Ī┴1ż╬│╬╬©├═ż└ĪŻ└Ķż╦Īó┐¶├═ż╦öU╠¾ż“▓├ż©żļż│ż╚ż½żķĪ╔Constrain then train╦ĪĪ╔ż╚żżż”żĶż”ż└ĪŻ

╝┬╣įż“╣įż”ź╣źčźżźŁź¾ź░ź═ź├ź╚ź’Ī╝ź»Ī╩īÜ┐▐Ī╦ż╦ż¬żżżŲ╝┬╣įĮĶ═²ż“│╬╬©┼¬(stochastically)ż╦╣įż”ĪŻ│žØ{żŪįużķżņż┐źĘź╩źūź╣ż╬└▄¶öŠ╩¾ż╬│╬╬©├═ż╦“£żż═┐¶ż“╚»Ö┌żĄż╗╝┬╣įż╣żļĪŻż▐ż┐└Łē”ż“æųż▓żļż┐żßż╦╩Ż┐¶ż╬│žØ{źŌźŪźļż“├ō┴TżĘĪó╝┬╣įżŪżŽ±T▓╠Ī╩Įą╬ü├═Ī╦ż“╩┐Ččż╣żļĪŻźóź¾źĄź¾źųźļ╦Īż╚Ė└ż”ĪŻ

Š}╦Īż╬äh▓┴ż“MNISTĪ╩Mixed National Institute of Standards and Technology database ź┘ź¾ź┴ź▐Ī╝ź»├ōźŪĪ╝ź┐ź┘Ī╝ź╣ĪóŠ}Į±żŁ┐¶ÖC0Īó1ĪóĪ”Ī”Ī”9ż╬Ū¦╝▒źŲź╣ź╚Ī󟥟żź║żŽ28Ī▀28źįź»ź╗źļĪóź░źņźżĪ╦ż╬źŪĪ╝ź┐ź╗ź├ź╚ż“├ōżżżŲ╣įż├żŲżżżļĪŻżĮż╬║▌ż╦TrueNorthŲŌż╬ź│źóżŽ30Ė─╗╚├ōżĘĪó64╩┬š`ż╬źóź¾źĄź¾źųźļ╦Īż“├ōżżżŲżżżļĪŻ1920ż╬ź│źóż“╗╚├ōżĘżŲżżżļĪŻ±T▓╠Īó99.42%ż╚╣Ōżż╗@┼┘ż“ĮążĘżŲżżżļĪŻ64╩┬š`ż╚żżż”┼┘╣ńżżż╬¾HżĄż╦Š»żĘČ├ż»ĪŻ

ź╦źÕĪ╝źĒźŌźļźšźŻź├ź»ż╚źŪźŻĪ╝źūźķĪ╝ź╦ź¾ź░Ī╩Back propagationĪ╦ż╚ż╬┤ųż╦▓═ż▒ČČż¼żŪżŁż┐ż│ż╚ż“┐āż╣╣®│ž┼¬ż╩┴T╠ŻżŪż╬║ŪĮķĪ╩ē¶żļĖ┬żĻżŪżŽĪ╦ż╬└«Ė∙╬ŃżŪżóżļĪŻ║ŻĖÕżŽżĶżĻĮjżŁż╩ź═ź├ź╚ź’Ī╝ź»ż╦ź╚źķźżż╣żļż│ż╚ż¼┤³┬įżĄżņżļĪŻ

(źż) ╚∙╩¼├═ŖZō¶╦Īż╬Ų│Ų■ż╚CNNżžż╬┼¼▒■Ī”Ī”Ī”ż│ż┴żķż¼╦▄╠┐?!

Ų¾╚ųų`ż╬Š}╦ĪżŪżóżļĪŻ║ŻŃQż╬3ĘŅż╦Ų▒żĖż»EsserĢ■ż½żķAirxivż╦┼ĻąMżĄżņż┐éb╩ĖĪ╩╗▓╣═½@╬┴44Ī╦ż╬ŲŌ═ŲżŪżóżļĪŻ║ŪŖZĪó9ĘŅ░╩æTĪóIBMż¼Įo╝░ż╦┼┼╗ęŠ╩¾(╗▓╣═½@╬┴109Īó110)ż╚żĘżŲŪ█┐«żĘżŲżżżļČ\Įčż╚└«▓╠żŪżóżļĪŻéb╩ĖżŽĪóµ£5ź┌Ī╝źĖż╬├µż╦┐ʿʿżŠ}╦ĪĪóCNNż╬╝┬äóĪóĘQ¹|ź┘ź¾ź┴ź▐Ī╝ź»ż╬±T▓╠ż¼Ą═żßżķżņżŲżżżļĪŻCNNżžż╬┼¼├ōżŌØ▓╩¼─_═ūżŪżóżļż¼ĖĒ║╣Ąš┼┴ś“╦Īż“ż╔ż╬żĶż”ż╦┼¼├ōżĘż┐ż½ż¼ÅRų`żĄżņżļĪŻ

┐ʿʿżŠ}╦ĪĪ╩╚∙╩¼├═ŖZō¶╦ĪĪ╦

Š}╦ĪżŽ▐kĖ└żŪ╔ĮĖĮż╣żļż╚Īóź╣źčźżźŁź¾ź░Įą╬üż“╚∙╩¼ż╣żļż╚╠ĄĖ┬Įjż╦ż╩ż├żŲżĘż▐ż”ż╬żŪĪó╚∙╩¼├═ż“└Ķż╦»éżßæ]ż┴żĘżŲżĘż▐ż¬ż”ż╚żżż”Š}╦ĪżŪżóżļĪŻ▓Šż╬ć@Š╬ż╚żĘżŲĪų╚∙╩¼├═ŖZō¶╦ĪĪūż╚żĘż┐ĪŻØi╣ÓżŪĮęż┘ż┐ĪóĪųConstrain then train╦ĪĪūż╚ż╬┤žĘĖżŽ£½ĄŁżĄżņżŲżżż╩żżĪ╩µ£ż»╩╠رż╚╗ūż’żņżļĪ╦ĪŻ

┐▐47ĪĪ╚∙╩¼├═ŖZō¶╦Ī(▓Š)ż╬ŲŌ═ŲĪĪĪ╩╗▓╣═½@╬┴110Īó111 ║Ū┐Ę╚Ūż“╗▓╣═ż╦║Ņ└«Ī╦

╝┬║▌ż╦żŽĪó┬Šż╦żżż»ż─ż½ż╬Š}╦Īż¼║╬żĻŲ■żņżķżņżŲż¬żĻ┐▐47ż╦ĄŁ║▄żĘż┐ĪŻż▐ż╚żßżļż╚│žØ{żŽĪóźąź├ź┴┘ćæä▓ĮĪ╩Batch NormalizationĪ¦╗▓╣═½@╬┴31Ī╦ż“╗╚ż├ż┐ĖĒ║╣Ąš┼┴ś“╦Īż“├ōżżżŲżżżļĪŻżĮż│ż╦ØiĮęż╬╚∙╩¼├═ŖZō¶╦ĪĪ╩┐▐47ż╬óżŖZō¶Ī╦Īóźęź╣źŲźĻźĘź╣Ī╩▐k╗■┤ųØiż╬Š╩¾ż“▐kŗ╗╚ż”Ī╦ż“├ōżżż┐▒Żżņ─_ż▀ż╬w(t)źóź├źūźŪĪ╝ź╚Š}╦ĪĪ󿥿ķż╦Spike sparsity pressureĪ╩ż│żņżŽ│žØ{╝┬╣į╗■ż╬╣®╔ūĪ╦ż╩żļŠ}╦Īż“├ōżżżŲżżżļĪŻ╚∙╩¼├═ŖZō¶╦ĪżŽ┘UŲ■┐▐ż╦┐āż╣żĶż”ż╦Īó╩č┐¶r(źšźŻźļź┐źņź╣ź▌ź¾ź╣├═)ż╬╩čŲ░ż╦×┤żĘżŲįÆ│čėXż╬╚∙╩¼├═ż“»éżßæ]ż┴żĘżŲżżżļĪŻ│žØ{ż╬ŗ╩¼ż╦┤žżĘżŲ┼÷ĮķżŽØ▓╩¼ż╦Įo│½żĄżņżŲżżż╩ż½ż├ż┐ż¼┘ć╝░éb╩Ėż╚ż╩żĻ╗▓╣═½@╬┴111(10ĘŅ11Ų³)ż╦ż½ż╩żĻ║┘ż½żżŠ}Įńż¼ĄŁżĄżņżŲżżżļĪŻ

CNN╝┬äóżŪż╬ź▌źżź¾ź╚

a.─_ż▀żŽ3├═Ī╩Trinary -1, 0, 1Ī╦Ī¦ 2014ŃQ┼÷ĮķżĶżĻĮj╔²ż╦į~┴Ū▓ĮĪ╩├Ļō■▓ĮĪ╦żĘżŲżżżļĪŻź▌źżź¾ź╚żŽźĘź╩źūź╣├═Ī╩─_ż▀Ī╦ż¼┐▐47ż╬īÜ▓╝ź░źķźšż╬żĶż”ż╦3├═Ī╩-1, 0, 1Ī╦ż“ŲDżļ┼└ż└ĪŻĪ▐1żŽČĮ╩│└Łż╚═▐öU└ŁźĘź╩źūź╣ż╦×┤▒■ż╣żļĪŻ0ż“▓├ż©żŲżżżļż╬żŽżĶżĻ╗@┼┘ż“æųż▓żļż┐żßż╚„[─ĻżĄżņżļĪŻż│ż╬3├═ż“ŲDżņżļ══ż╦ż╣żļż┐żßż╦Īó(1)źóź»źĮź¾ż╬ź┐źżźūż“2¹|╬ÓĪ╩ØiĮężŪżŽ4¹|Ī╦ż╚żĘżĮż╬├═żŽźūźķź╣1ż╚ź▐źżź╩ź╣1Ī╩╔w─ĻĪ¦ØiĮężŪżŽ9bitĪ╦Ī󿥿ķż╦(2)TrueNorthż╬╝┬äóżŪżŽź┌źóĪ╝Ų■╬üöĄ╝░ż“ż╚żļĪŻ▐kż─ż╬ź╣źčźżź»┐«ęÄż“źūźķź╣Ż▒ż╚ź▐źżź╩ź╣Ż▒ż╬2ż─ż╬źóź»źĮź¾ż╦Ų▒╗■ż╦Ų■żņżļĪŻżĮżĘżŲĪó╬Š┐«ęÄż“(3)źĘź╩źūź╣ź▐ź╚źĻź»ź╣ż╬ź½źķźÓæųżŪŽ┬ż“ŲDżĻźūźķź╣1(źūźķź╣Ŗõż└ż▒ź¬ź¾)Īóź▐źżź╩ź╣1ĪóżĮżĘżŲź╝źĒż“║ŅżļĪ╩╬ŠöĄż╚żŌźĘź╩źūź╣└▄¶öż“ź¬ź¾żĄż╗żļĪ╦ĪŻ±T▓╠źĒĪ╝Ŗõż╬Ė·╬©żĄżķż╦żŽź┴ź├źūż╬ĀC└čĖ·╬©ż“1/2ż╚ĄŠ└Ęż╦żĘżŲ3├═źĘź╩źūź╣ż“║ŅżĻĮążĘżŲżżżļĪŻż┴ż╩ż▀ż╦Īóźóź»źĮź¾żžżŽ1Ų■╬üż╚żĘźĘź╩źūź╣╔ķ▓┘ż“3¹|╬Óż╚ż╣żļż│ż╚żŌ▓─ē”ż╚╗ūż’żņżļĪŻż╩ż╝ź┌źóĪ╝Ų■╬üż╚żĘż┐ż╬ż½żŽ╔į£½ĪŻż╩ż¬Īóż█ż▄Ų▒╗■┐╩╣įżŪź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŪżŌ¾Hż»ż╬Ė”ē|ĪóØŖż╦źŌź¾ź╚źĻź¬Ī╝źļĮj│žż╬Bengio└ĶÖ┌ż╬ź░źļĪ╝źūż“├µ┐┤ż╦Binaryż¬żĶżėTernary(æųĄŁż╬Trinaryż╚Ų▒żĖ)ż╬Ė”ē|ż¼ż╩żĄżņżŲżŁż┐ĪŻŲ╚╬®ż╦┐╩ż¾ż└ż╚żŽżżż©╗■┤³┼¬ż╦żŽŲ▒┤³żĘżŲżżżļĪŻ

b.øQ╣■ż▀┴žż╬╝┬äóĪ¦ ź┌źóĪ╝Ų■╬üżŪżóżļż│ż╚ż½żķŲ■╬üż╬┐¶ż╬║ŪĮjżŽ128ż╚ż╩żļĪŻź═ź├ź╚ź’Ī╝ź»ż╬Ū█ÅøöĄ╦Īż╬╣═ż©öĄż╬┤╦▄żŽĪóøQ╣■ż▀┴žż╬źšźŻźļź┐żŽ4╝ĪĖĄĪ╩Ų■╬üØŖ─¦ź▐ź├źū┐¶Īó2╝ĪĖĄźšźŻźļź┐ĪóĮą╬üØŖ─¦ź▐ź├źū┐¶Ī╦ż└ż¼Īó╔į▓─╩¼ż╬║ŪĮķż╬3╝ĪĖĄ╩¼ż“1ż─ż╬ź½źķźÓż╦×┤▒■żĄż╗żļ┼└ż╦żóżļĪŻżĮż╬±T▓╠Īó1źĄźżź»źļ(1ms)żŪ3╝ĪĖĄż╬└čŽ┬ż¼▐kż─ż╬ź½źķźÓĪóź╦źÕĪ╝źĒź¾żŪ╣įż©żļĪŻĪ╩ż╩ż¬Īó┤÷ż─ż½ż╬╩╠░ŲżŌ▓─ē”żŪżóżļĪ╦ĪŻ

┐▐48ż╦øQ╣■ż▀┴žż╬·t│½ż“┐▐┐āżĘż┐ĪŻ4╝ĪĖĄų`ż╬Įą╬üØŖ─¦ź▐ź├źūżžż╬×┤▒■żŽź½źķźÓż╬▓ŻöĄĖ■·t│½żŪ×┤▒■ż╣żļĪŻĮą╬üØŖ─¦ź▐ź├źūż╬║ŪĮj┐¶żŽ256ź▐ź├źūż╚ż╩żļĪŻ▐kĮų(1ms)żŪ╝ŖōQż¼Į¬╬╗ż╣żļĪŻż┐ż└żĘĪó1ź│źóżŪĮĶ═²Įą═Ķżļż╬żŽĮą╬üź▐ź├źūż╬1ź╬Ī╝ź╔╩¼ż└ż▒żŪżóżļĪŻ═²„[┼¬ż╦żŽ4096ź│źó┘T║▀ż╣żļż╬żŪĪó4096ź╬Ī╝ź╔Ų▒╗■ĮĶ═²ż¼▓─ē”ż└ĪŻ

żĘż½żĘĪó╝┬äóæųżŽ2ż─ż╬▓▌¼öż¼┘T║▀ż╣żļĪŻ(1)źšźŻźļź┐Ī╝źĄźżź║ż╩żĻŲ■╬üØŖ─¦ź▐ź├źū┐¶ż¼¾Hżżż╚ż╣ż░╦■ÜJĪ╩128Ų■╬üĪ╦ż╦ż╩żļĪŻż│żņżŽź»źĒź╣źąĪ╝öĄ╝░Ī󿥿ķż╦żŽź╦źÕĪ╝źĒźŌźļźšźŻź├ź»żŪżŽŲ¼ż╬─╦żż┼└żŪżóżļĪŻØŖż╦ĖÕŪvż╬Šņ╣ńżŽ²ŗ├µż╦ź╦źÕĪ╝źĒź¾övŽ®ż“▓ż╣żļĪŻżĮż╬ż│ż╚ż½żķ3╝ĪĖĄ╩¼ż╬źšźŻźļź┐ż╬└čŽ┬ż¼▐k╚╠┼¬ż╦żŽ╔į▓─╩¼ż╦ż╩żļĪŻż│ż╬┼└żžż╬Ū█╬Ėż¼ØŁ═ūż└ĪŻ├°ŪvżķżŽź░źļĪ╝źū▓Įż╚żżż”╣═ż©ż“╗╚├ōżĘżŲżżżļĪŻ╩Ż┐¶ż╬Ų■╬üØŖ─¦ź▐ź├źūż“ź░źļĪ╝źįź¾ź░żĘżŲŗ╩¼Ž┬ż“╣įż”ĪŻØŖ─¦ź▐ź├źūż╬źņź┘źļżŪżżż”ż╩żķżąĪóµ£±T╣ńżŪżŽż╩ż»ŗ╩¼±T╣ńż“╣įż”Ą£ż╦┴Ļ┼÷ż╣żļĪŻż│ż╬ż│ż╚żŽ╝┬║▌ż╬ź»źķź╣▓ĮżŪż╬µ£±T╣ńżŪżŌŲ▒══ż└ĪŻ╗@┼┘ż“æųż▓żĶż”ż╚żĘż┐║▌ż╦▒Ųūxż¼Įążļ▓─ē”└Łż¼żóżļĪŻ(2)╝ĪżŽTrueNorthż╬źóĪ╝źŁźŲź»ź┴źŃØŖŃ~ż╬Ų■╬üŖõżŪż╬╠õ¼öżŪ╦▄ä®┼¬żŪżŽż╩żżĪŻŲ■╬ü├═ż╬╩Ż┐¶ź│źóżžż╬ź▐źļź┴źŁźŃź╣źŲźŻź¾ź░ż¼żõżĻż╦ż»żż┼└ż└ĪŻ×┤▒■ż╚żĘżŲTrueNorthżŪżŽź│źóż“ź▐źļź┴źŁźŃź╣źŲźŻź¾ź░├ōövŽ®└ņ├ōż╚żĘżŲ╗╚├ōż╣żļĪŻź│źó┴ž┐¶ż╬ż½ż╩żĻż╬│õ╣ńżŪ╗╚├ōżĄżņżļĪŻ

CNNĪóHGMM(hierarchical Gaussian mixture model)Ī󿬿ĶżėBLSTM (bidirectional long short-term memory)żž┼¼├ōżĘż┐ź┘ź¾ź┴ź▐Ī╝ź»ż╬±T▓╠ż¼ĮążĄżņżŲż¬żĻĪó╬╔żż±T▓╠ż╚ż╬ż│ż╚żŪżóżļĪŻ║ŻĖÕżĶżĻĮjżŁż╩æä╠Žż╬źŌźŪźļżžż╬┼¼├ōż¼┤³┬įżĄżņżļĪŻ

┐▐48ĪĪøQ╣■ż▀┴žż╬ź│źóĪ╩ź»źĒź╣źąĪ╝Ī╦żžż╬·t│½öĄ╦ĪĪ¦Ī╩╗▓╣═½@╬┴45ż“╗▓╣═ż╦║Ņ└«Ī╦

(ź”) ░ĄĮ╠╦Ī (Deep Compression┼∙)ż╚╚µ│ė Ī”Ī”Ī” ż½ż╩żĻäė░·ż└ż¼Ī¬

┐▐49ż╦║YØŹ┼¬ż╩TrueNorthżŪ└Ō£½żĄżņżŲżżżļźčźķźßĪ╝ź┐ż╬└▀─ĻöĄ╦Īż“┐āżĘż┐ĪŻźĘź╩źūź╣ĘĖ┐¶żŽŲ■╬ü║ĖŖõż╬╚ų├Ž(i)ż╚Įą╬ü▓╝Ŗõż╬╚ų├ŽĪ╩jĪ╦żŪ»éż▐żļöĄ╝░ż└ĪŻŲ■╬üŖõż╬źóź»źĮź¾żŽ4¹|╬Óż╬ź┐źżźūż¼żóżļĪŻżĮż╬ź┐źżźūż╦źĘź╩źūź╣├═ż“│õżĻ┼÷żŲżļĪŻ

┐▐49ĪĪTrueNorthż╬▒ķōQŗ╩¼ż“░ĄĮ╠ż╚żżż”£å┼└żŪż╬ŖZō¶

╬╠╗ę▓ĮĪ¦ż│ż│żŪĪóDeep Compressionż╬╬╠╗ę▓Įż╚╚µ│ėżĘżŲż▀żļĪŻČ”ż╦ź│Ī╝ź╔źųź├ź»ż“ŠW├ōżĘż┐ź»źķź╣ź┐Ī╝▓Įż╬Š}╦Īż“├ōżżżŲżżżļĪŻTrueNorthż╬Šņ╣ńż╦żŽ4¹|╬ÓĪóDeep Compressionż╬Šņ╣ńżŽĪó▐k╬Ńż╚żĘżŲøQ╣■ż▀┴žż╦256(8źėź├ź╚)¹|╬ÓĪóµ£±T╣ń┴žż╦32Ī╩5źėź├ź╚Ī╦¹|╬Óż“│õżĻ┼÷żŲżŲżżżļĪŻTrueNorthżŽ2źėź├ź╚ĪóDeep CompressionżŽ╩┐ČčżŪ5.4źėź├ź╚ż└ĪŻż▐ż┐żĮżņżŠżņż╬¹|╬ÓżŽ┬Õ╔Į├═Ī╩CentroidĪ╦ż╚Š╬żĘżŲTrueNorthżŽ9źėź├ź╚(-256Ī┴255)ĪóDeep CompressionżŽ32źėź├ź╚ż╬├═ż¼═┐ż©żķżņżļĪŻż╩ż¬ĪóTrueNorthż╬Šņ╣ńżŽź½źķźÓĪ╩ź╦źÕĪ╝źĒź¾Ī╦ż╬░╠Åøż╦żĶżĻŲ╚╬®żĘżŲ├═ż“256¹|╬Ó┬ōż┘żļż¼Īó╝┬żŽźĒĪ╝Ī╩źóź»źĮź¾Ī╦Ŗõż╬256źĒĪ╝żŪČ”Ń~ż╣żļż│ż╚ż½żķ┴Ļ£¹żĄżņżļĪŻ±T▓╠Īó╚µ│ėż╣żļż╚5.4źėź├ź╚(Deep Compression)ż╚2źėź├ź╚Ī╩TrueNorthĪ╦ż╬║╣ż╚ż▀żļż│ż╚ż¼żŪżŁżļĪŻ

Pruning/ź╝źĒź╣źŁź├źūĪ¦Ų▒══ż╦ĪóPruningż╚ź╣źčźżźŁź¾ź░ż“╣═ż©żŲĖ½żļĪŻČ”ż╦żĘżŁżż├═ż╦żĶżĻĮjżŁż╩źŪĪ╝ź┐╬╠ż╬░ĄĮ╠ż“╣įż├żŲżżżļĪŻØiŪvżŽ└▄¶öĪ╩─_ż▀ż╬ĮjżŁżĄżŪ╚Į─ĻĪ╦żĮż╬żŌż╬ĪóĖÕŪvżŽĮą╬üżĮż╬żŌż╬Ī╩└čŽ┬ż╬├═żŪ╚Į─ĻĪ╦ż“└┌żĻ╝╬żŲżļĪŻżĘżŁżż├═żŽĄ£Øiż╦»é─ĻżĄżņżļĪŻżĮżĘżŲØiŪvżŽź╣ź┐źŲźŻź├ź»ż╦ĪóĖÕŪvżŽź└źżź╩ź▀ź├ź»ż╦└┌żĻ╝╬żŲż¼╣įż’żņżļĪŻ╚∙öéż╦░█ż╩żļż¼Īóż½ż╩żĻ╬Óō¶┼└żŽżóżļĪŻż▐ż┐Deep Compression┼∙ż╦żŽź╝źĒź╣źŁź├źūż╚żżż├ż┐źŲź»ź╦ź├ź»żŌżóżļĪŻź└źżź╩ź▀ź├ź»ż╦╚Į─ĻżĘżŲżżżļ┼└żŪżŽż│ż┴żķż╬öĄż¼ō¶żŲżżżļż╚Ė└ż©żļĪŻĮj╗©Ū─ż╦ż▐ż╚żßżļż╚ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŪżŽ╝ńż╦╗╚ż’żņżļīÖ└Ł▓Į┤ž┐¶ReLU(Rectified linear Unit)ż╦żĶżĻĪóż▐ż┐ź╣źčźżźŁź¾ź░ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŽĪóź╣źčźżźŁź¾ź░ż╦żĶżĻźŪĪ╝ź┐ż╬šÅżķżĄż¼▓├Å]żĄżņżļĪŻ

ż▐ż╚żßĪ¦─╠Š’ż╬ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŌ░ĄĮ╠Č\Įčż“▓├ż©żļż│ż╚ż╦żĶżĻĪóż½ż╩żĻź╣źčźżźŁź¾ź░ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»ż╦ŖZż»ż╩ż├żŲżŁż┐ż╚ż▀żļż│ż╚ż¼żŪżŁżļĪ╩╝┬żŽ90ŃQ┬Õż╦╬ŠŪvż¼╚µ│ėżĄżņż┐║»└ūż¼żóżļĪ╦ĪŻ╦▄┤¾ąMżŪżŽŲDżĻ░Ęż’ż╩ż½ż├ż┐Binary Connectż╩żĻBinarized NetworkżĄżķż╦żŽTernary NetworkżŪżĶżĻŖZżżØ±ż╦ż╩żļż╚╣═ż©żļĪŻ

żĮżĒżĮżĒ╣®│ž┼¬ż╩┴T╠ŻżŪż╬ĖĪŲżżŌ▐k─Ļż╬├╩│¼ż╦Ų■ż├ż┐ż╚Ū¦╝▒żĘżŲżżżļĪŻź╦źÕĪ╝źĒźŌźļźšźŻź├ź»żŌżĘż»żŽź╣źčźżźŁź¾ź░ź╦źÕĪ╝źķźļź═ź├ź╚ź’Ī╝ź»żŪż╬┐Ęż┐ż╩ź╣źŲĪ╝źĖż¼┤³┬įżĄżņżļĪŻ

įćĮĖÅRĪ╦╝å└źĢ■ż╬ĖĮ║▀ż╬Ė¬Į±żŽĪóĒ×ķL╠OĮj│ž Įj│ž▒ĪŠ╩¾▓╩│žĖ”ē|▓╩ │žĮčĖ”ē|µ^żŪżóżļĪŻ